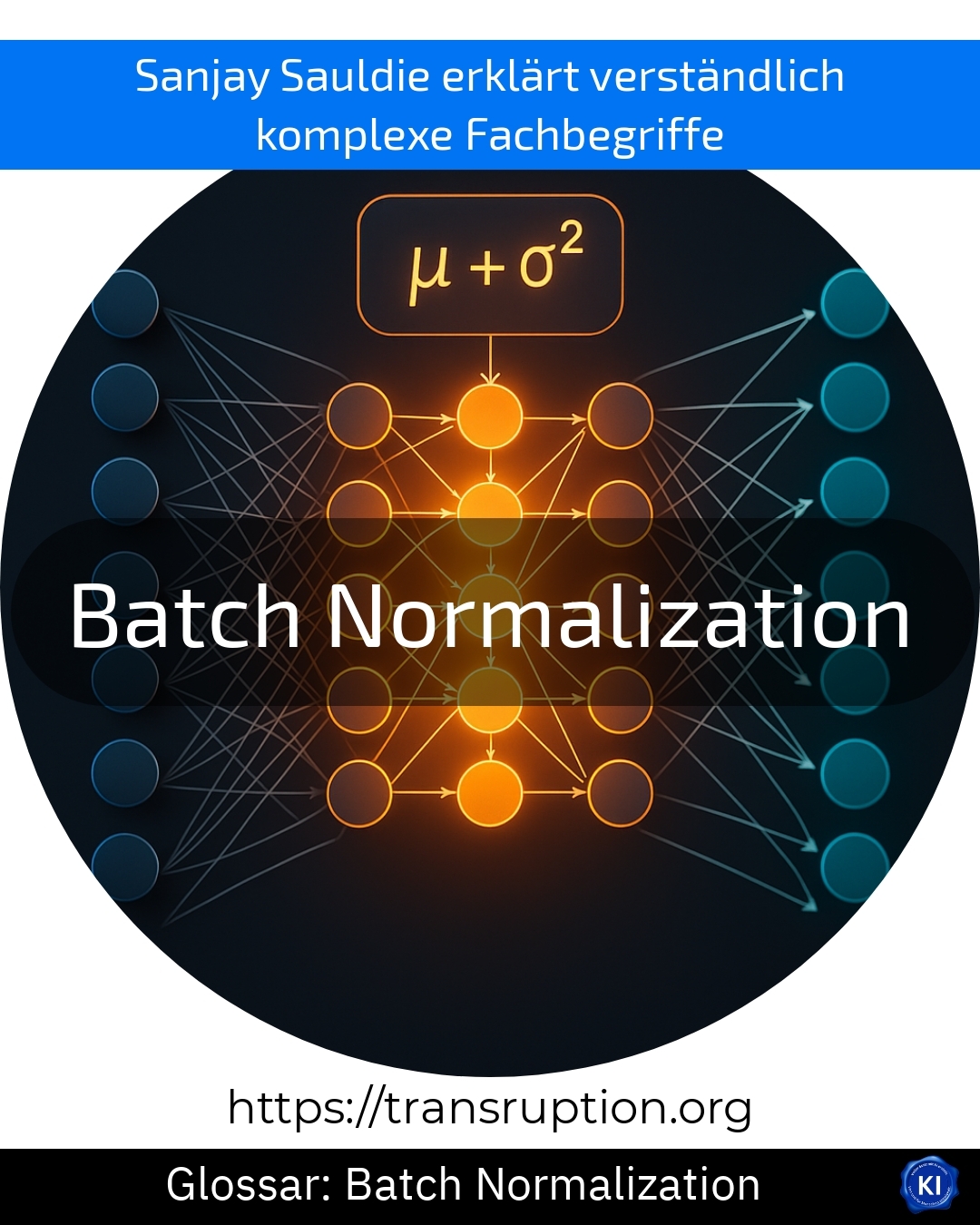

Batch normalisation is a term used in artificial intelligence and is primarily used to train neural networks. Such networks are used, for example, to automatically recognise images or understand speech.

Think of batch normalisation as a kind of "refresher course" for the data in a machine. During training, neural networks receive a lot of different data at the same time, so-called "batches". Without batch normalisation, it can happen that some areas of the network react too strongly and others too weakly. This makes learning more difficult and slower for the machine.

With batch normalisation, the data within each batch is brought to a similar state. This creates a healthy balance and ensures that the network learns more quickly and stably.

A simple example: you want to teach an artificial intelligence to recognise dogs and cats in photos. Batch normalisation helps to "serve" uniform and easy-to-understand images so that the machine can distinguish more quickly and with fewer errors whether it sees a dog or a cat. This saves a lot of training time and significantly improves the end result.